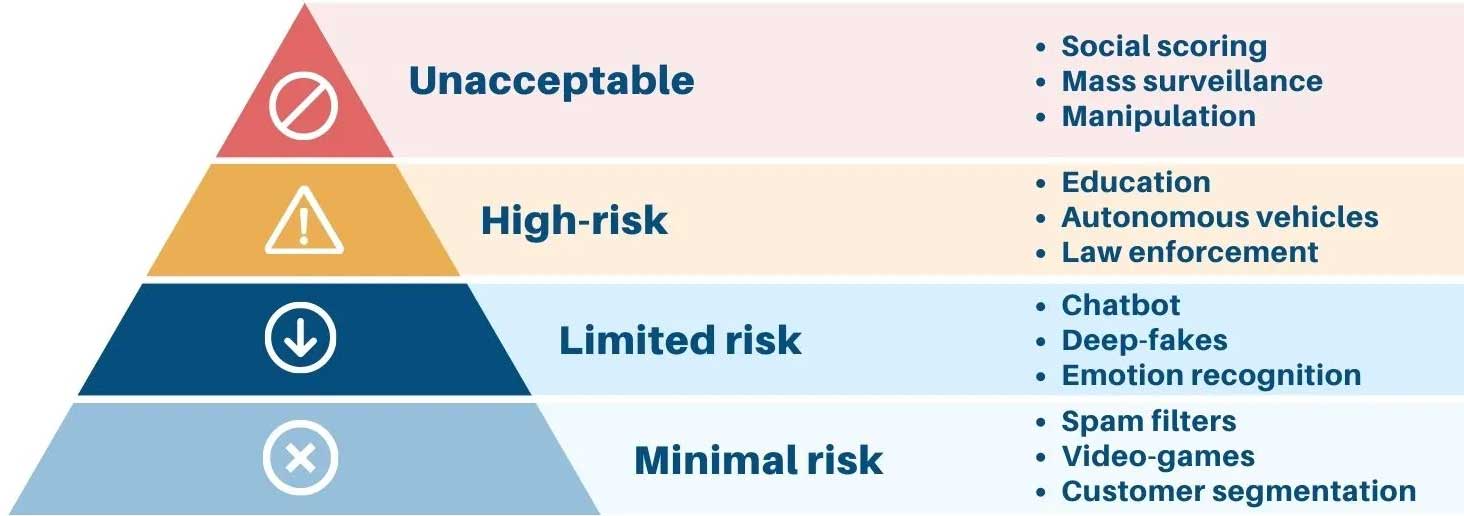

سطوح ریسک سامانههای هوش مصنوعی

در قانون هوش مصنوعی اتحادیه اروپا (EU AI Act)

قانون هوش مصنوعی اتحادیه اروپا، چارچوبی قانونی برای توسعه و استفاده از هوش مصنوعی در اتحادیه اروپا ارائه میدهد که به دلیل جامعیت، یکپارچگی و بهروزآوری مستمر، علاوه بر ۲۷ کشور اتحادیه اروپا، مستقیماً الهامبخش بسیاری از کشورهای توسعهیافته از جمله ایالات متحده آمریکا، کانادا، بریتانیا (حتی پس از Brexit)، استرالیا، سنگاپور، ژاپن، امارات متحده عربی در تدوین قوانین هوش مصنوعی بوده است.

این قانون، سامانههای هوش مصنوعی را با تمرکز بر ریسکهای اخلاقی آنها از جمله تبعیض، نقض حریم خصوصی و سوگیری، به چهار دسته ریسکهای غیرقابلقبول، بالا، محدود و پایین تقسیم میکند که تعاریف و نمونههایی از هریک در ادامه بیان شده است.

۱. ریسک غیرقابلقبول:

این دسته شامل سامانههایی میشود که خطرات جدی برای سلامتی، ایمنی یا حقوق اساسی انسان ایجاد میکنند. در حال حاضر استفاده از این سامانهها در اتحادیه اروپا ممنوع است.

نمونهها:

– سامانههای هوش مصنوعی که برای تشخیص و درمان خودکار بیماریها بدون دخالت انسان استفاده شده و میتوانند منجر به تشخیص نادرست و آسیب احتمالی به بیمار شوند.

– سامانههای هوش مصنوعی که برای تشخیص خودکار چهره افراد در اماکن عمومی و بدون رضایت آنها استفاده میشوند. [۱]

– سامانههای هوش مصنوعی که برای پیشبینی جرم و جنایت و بدون استناد به شواهد موردنیاز دستگاه قضایی در مورد یک فرد یا سازمان خاص استفاده میشوند و میتوانند منجر به بازداشت و زندانیشدن افراد بیگناه شوند.

– سامانههای هوش مصنوعی که برای سلاحهای خودکار و بدون دخالت انسان استفاده میشوند.

۲. ریسک بالا:

این دسته شامل سامانههایی میشود که خطرات قابلتوجهی برای سلامتی، ایمنی یا حقوق اساسی انسان ایجاد میکنند. استفاده از این سامانهها فقط در صورت رعایت الزامات سختگیرانه قانونی مجاز است.

نمونهها:

– سامانههای هوش مصنوعی که برای استخدام افراد استفاده میشوند و میتوانند منجر به تبعیض در استخدام شوند یا برای رتبهبندی اعتباری افراد استفاده میشوند و میتوانند منجر به محرومیت مالی افراد از برخی امتیازات مالی شوند.

– سامانههای هوش مصنوعی که برای تشخیص خودکار بیماریها بدون دخالت انسان (باتوجهبه نوع بیماری و بهعنوان ابزار کمکی پزشک) و با استفاده از دادههای ناقص یا نامعتبر استفاده میشوند.

– سامانههای هوش مصنوعی که برای رتبهبندی اعتباری افراد و بدون درنظرگرفتن شرایط فردی آنها استفاده میشوند و میتوانند منجر به محرومیت مالی افراد شوند.

۳. ریسک محدود:

این دسته شامل سامانههایی میشود که خطرات جزئی برای سلامتی، ایمنی یا حقوق اساسی انسان ایجاد میکنند. استفاده از این سامانهها با نظارت محدود مجاز است.

نمونهها:

– سامانههای هوش مصنوعی که برای توصیه محصولات به مشتریان در وبسایتهای خرید آنلاین یا برای چتباتها در خدمات مشتری استفاده میشوند.

– سامانههای هوش مصنوعی که برای تشخیص چهره افراد در تصاویر (مثلاً تصاویر افراد در اینترنت) و با رضایت آنها استفاده میشوند.

۴. ریسک پایین:

این دسته شامل سامانههایی میشود که خطرات قابلتوجهی برای سلامتی، ایمنی یا حقوق اساسی انسان ایجاد نمیکنند. استفاده از این سامانهها بدون هیچ محدودیتی مجاز است.

نمونهها:

– سامانههای هوش مصنوعی که برای بازیهای کامپیوتری یا فیلترکردن اسپم در ایمیلها استفاده میشوند.

– سامانههای هوش مصنوعی که برای تشخیص چهره افراد در تصاویر و برای مقاصد امنیتی مانند ورود به سیستم استفاده میشوند.

علاوه بر سطوح ریسک گفته شده در بالا، قوانین هوش مصنوعی اتحادیه اروپا (EU AI Act) الزاماتی را برای توسعهدهندگان و کاربران سامانههای هوش مصنوعی در نظر گرفته است. این الزامات شامل مواردی مانند شفافیت، انصاف و پاسخگویی میشود. از نقاط برجسته در این قانون رویه بهبود مستمری است که برای آن در نظر گرفته شده و از زمان تدوین تا کنون بهصورت دائم در حال بهبود و تکامل بوده است.

به نظر میرسد لازم است مهندسین، طراحان و بهرهبرداران سامانههای هوش مصنوعی، برای هریک از ماژولها و کارکردهای سامانه هوشمند خود، این دستهبندی را در نظر داشته و ریسکهای وارد بر هریک از سامانههای خود را برآورد نمایند تا بهمرورزمان شاهد افزایش کاربردهای مؤثر و کاهش مخاطرات استفاده از سامانههای هوش مصنوعی باشیم.

______________________________________

[۱] معمولا دولتها یا نهادهای نظارتی به دلایلی مانند حفاظت از امنیت ملی یا مواردی از این دست، اقدام به استفاده فراگیر از سامانههای تشخیص چهره مینمایند، اما بر اساس قوانین معمول سامانههای هوش مصنوعی، بایستی این سامانهها تنها امکان شناسایی چهره مظنونین یا متهمینی را داشته باشند که با حکم دستگاه قضایی به عنوان مظنون یا متهم، بایستی مورد شناسایی یا تعقیب قرار گیرند و در صورت تطبیق چهره ایشان، مورد را به نهاد نظارتی گزارش نمایند؛ در حالی که دولتها تمایل دارند سامانههای تشخیص چهره را به صورت فراگیر، برای عموم مردم و بدون رضایت فردی ایشان مورد استفاده قرار دهند که این خود از آسیبهای اجتماعی بسیار مهم در کاربرد سامانههای هوش مصنوعی به شمار میرود.

لینک کوتاه b2n.ir/airisks برای ارجاع ساده این مطلب درنظرگرفته شده است.

وب سایت علیرضا صائبی وبلاگ علیرضا صائبی

وب سایت علیرضا صائبی وبلاگ علیرضا صائبی