چارچوب HLEG AI و ارزیابی هوش مصنوعی قابل اعتماد (ALTAI[1])

هر روز دستاورد جدیدی در حوزه هوش مصنوعی (AI) ارائه میشود و تأثیرات گسترده آن بر جوامع، صنایع و حتی زندگی روزمره انسانها با سرعت زیادی در حال گسترش است.

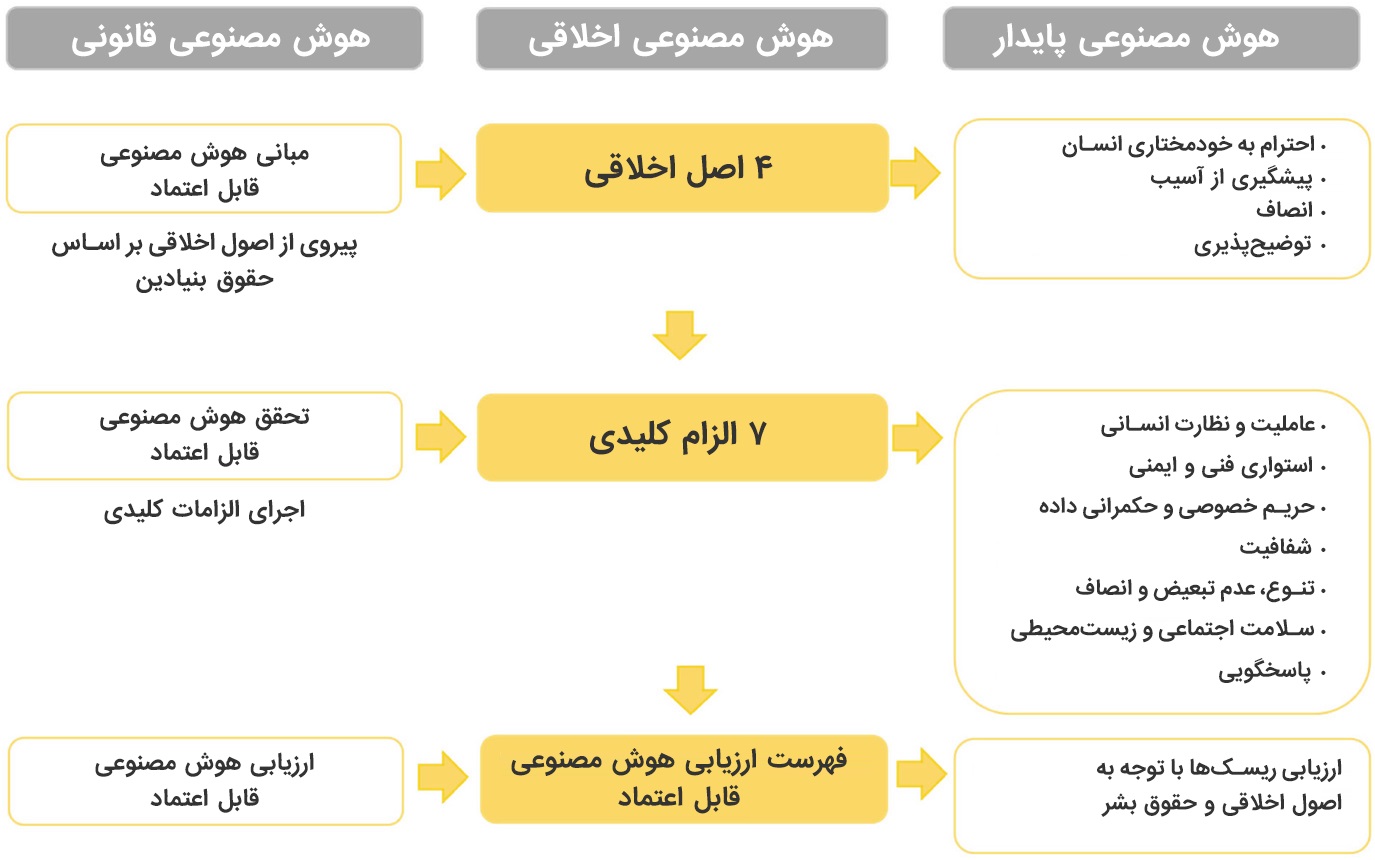

با توجه به سرعت پیشرفت این فناوری، توجه به جنبههای اخلاقی و اجتماعی آن اهمیت بیشتری پیدا کرده است. در این راستا، گروهی از کارشناسان ارشد هوش مصنوعی (HLEG AI) در سال ۲۰۱۸ برای ارائه رهنمودهای اخلاقی در طراحی و کاربردهای AI در کمیسیون اروپا تشکیل شد. این گروه با هدف ایجاد چارچوبی برای توسعه و استفاده مسئولیانه از هوش مصنوعی، دستورالعملهایی برای ایجاد هوش مصنوعی قابل اعتماد و اخلاقی تدوین کرد که در نهایت منجر به ایجاد «فهرست ارزیابی هوش مصنوعی قابل اعتماد» (ALTAI) شد.

ALTAI: ارزیابی هوش مصنوعی قابل اعتماد

فهرست ارزیابی هوش مصنوعی قابل اعتماد (ALTAI) بهعنوان ابزاری برای ارزیابی سیستمهای هوش مصنوعی طراحی شده است تا اطمینان حاصل کند که این سیستمها با اصول اخلاقی سازگار هستند. ALTAI بر پایه چهار اصل اخلاقی بنا شده که در تمام مراحل توسعه و پیادهسازی سیستمهای هوش مصنوعی باید رعایت شوند. این اصول عبارتند از:

- احترام به استقلال انسانی: سیستمهای هوش مصنوعی باید بهگونهای طراحی شوند که تصمیمگیریهای انسانها را تضعیف نکنند و امکان نظارت و دخالت انسانی در فرایندها حفظ شود.

- پیشگیری از آسیب: باید اطمینان حاصل شود که استفاده از هوش مصنوعی هیچگونه آسیبی به افراد یا جوامع وارد نمیکند. این اصل بر اهمیت ایمنی و جلوگیری از آسیبهای غیرقابلپیشبینی تأکید دارد.

- عدالت: سیستمهای هوش مصنوعی باید بهطور عادلانه عمل کنند و هیچگونه سوگیری و تبعیضی در فرآیندهای خود نداشته باشند. این شامل جلوگیری از تبعیض بر اساس نژاد، جنسیت، سن یا سایر ویژگیهای فردی است.

- توضیحپذیری: تصمیماتی که توسط سیستمهای هوش مصنوعی اتخاذ میشوند باید قابل توضیح و شفاف باشند. افراد باید قادر باشند بفهمند که یک تصمیم خاص ماشینی چرا و چگونه گرفته شده است.

هفت الزام کلیدی ALTAI

در ادامه این چهار اصل، ALTAI هفت الزام کلیدی را معرفی میکند که برای عملیاتی کردن این اصول ضروری هستند. این الزامات عبارتند از:

- عاملیت انسانی و نظارت: سیستمهای هوش مصنوعی باید طوری طراحی شوند که امکان نظارت انسانی را فراهم کنند. نظارت میتواند بهصورت «انسان در چرخه تصمیمگیری» (Human-in-the-loop)، «انسان ناظر بر چرخه تصمیمگیری» (Human-on-the-loop) یا «انسان مسئول چرخه تصمیمگیری» (Human-in-command) باشد.

- پایداری و ایمنی فنی: سیستمهای هوش مصنوعی باید از نظر فنی مقاوم، پایدار و ایمن باشند و در برابر تهدیدات و مشکلات قابلپیشبینی محافظت شوند.

- حریم خصوصی و مدیریت دادهها: حفاظت از حریم خصوصی افراد و اطمینان از مدیریت صحیح دادهها باید از اولویتهای کلیدی سیستمهای هوش مصنوعی باشد.

- شفافیت: شفافیت باید در فرآیندهای تصمیمگیری سیستمهای هوش مصنوعی حفظ شود و کاربران و ذینفعان باید بتوانند به راحتی اطلاعات مربوط به چگونگی عملکرد سیستم را درک کنند.

- تنوع، عدم تبعیض و عدالت: طراحی سیستمهای هوش مصنوعی باید به صورتی انجام شود که از سوگیری و تبعیض جلوگیری کرده و به ترویج تنوع و عدالت کمک کند.

- سلامت اجتماعی و زیستمحیطی: باید تأثیرات اجتماعی و زیستمحیطی استفاده از هوش مصنوعی بهدقت ارزیابی و کنترل شود.

- پاسخگویی و مسئولیتپذیری: در نهایت، هر سیستم هوش مصنوعی باید مسئولیتپذیر باشد و هرگونه پیامد یا اثر منفی باید بهطور شفاف پیگیری و اصلاح شود.

کاربردهای ALTAI

چارچوب ALTAI کاربردهای متنوعی دارد. در سطح دولتی، این چارچوب میتواند به تدوین خطمشیها، راهبردها، سیاستها و مقررات کمک کند تا استفاده از هوش مصنوعی بهطور اخلاقی و مسئولانه صورت گیرد. در سطح صنعتی، شرکتها میتوانند از این چارچوب برای ارزیابی و طراحی سیستمهای هوش مصنوعی استفاده کنند تا اطمینان حاصل کنند که محصولات و خدمات آنها مطابق با استانداردهای اخلاقی و قانونی هستند.

بهطور خاص، استفاده از ALTAI در سازمانهای بزرگ میتواند به ارزیابی خطرات و فرصتهای مرتبط با پیادهسازی هوش مصنوعی کمک کند و اطمینان حاصل کند که فرآیندهای تصمیمگیری هوش مصنوعی به نفع رفاه اجتماعی و توسعه پایدار هستند. این ارزیابی میتواند به سازمانها کمک کند تا از مشکلاتی مانند تبعیض الگوریتمی، نقض حریم خصوصی و خطرات امنیتی جلوگیری کنند.

مثلا فرض کنید یک شرکت در حال توسعه یک سیستم هوش مصنوعی برای خودران کردن وسایل نقلیه است. با استفاده از چارچوب ALTAI، این شرکت میتواند از اصولی مانند «پیشگیری از آسیب» و «پایداری فنی» برای ارزیابی خطرات احتمالی سیستم خود استفاده کند. علاوه بر این، از اصل «شفافیت» برای توضیح چگونگی عملکرد سیستم به کاربران و ناظران استفاده میکند تا اطمینان حاصل شود که در صورت بروز خطا، مسئولیتها بهوضوح مشخص باشند.

چارچوب HLEG AI و فهرست ارزیابی هوش مصنوعی قابل اعتماد (ALTAI) ابزارهای مهمی برای تضمین استفاده اخلاقی و مسئولانه از هوش مصنوعی هستند. با رعایت این اصول و الزامات، میتوان هوش مصنوعی را بهطور مؤثر و عادلانه در جامعه پیادهسازی کرده و از پیامدهای منفی آن جلوگیری کرد.

استقرار این چارچوب در شرکتها و سازمانها روشهای ساختیافته و مشخصی دارد که امیدوارم بتوانم در آینده بیشتر از آن بنویسم.

[۱] Assessment List for Trustworthy Artificial Intelligence

وب سایت علیرضا صائبی وبلاگ علیرضا صائبی

وب سایت علیرضا صائبی وبلاگ علیرضا صائبی